画像生成AI「Stable Diffusion」で遊ぶ

2022.12.22

■概要

画像生成AI「Stable Diffusion」で遊んでみる。

数年前に話題になった「Style GAN」の進化系。

text2img といって文字列から画像を生成してくれる。内部的にはtransformerを使って文脈を把握してから画像の生成を行っている。

■準備

・画像生成モデルを作るのに良いGPUを積んだハイスペックマシンでも何週間もかかると思われる。

「Stable Diffusion」がモデルを公開してくれているのでありがたく利用させていただく。

・開発機に「GeForce RTX 2070」を積んでおり、CUDAのバージョン「11.3.1」をインストールし、その他各種ライブラリをインストール。

いろいろエラーが出るので、動作環境作るのに数時間はかかる。

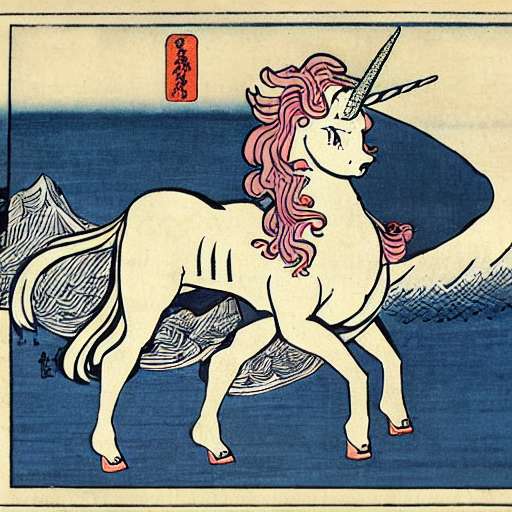

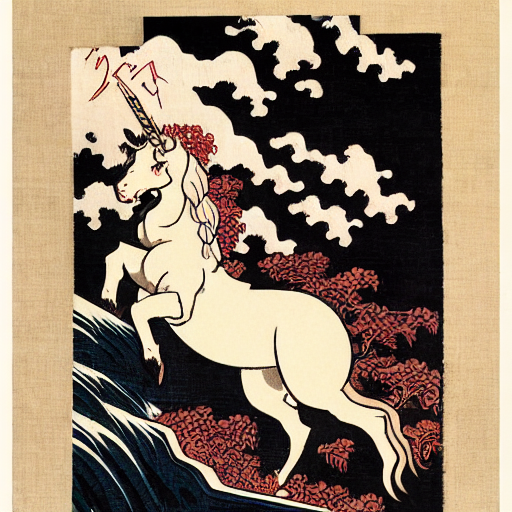

■テスト用入力文字列

「unicorn by Katsushika Hokusai」(葛飾北斎風のユニコーン)

■生成結果

※使用するマシンによるが、生成時間は1画像あたり30秒程度。

■感想

・イメージ通りの結果を出させるのはなかなか難しいので、入力文字を工夫する必要がある。

画像生成の際、色々なパラメータがあるので、それらをチューニングすればイメージに近づけると思われる。

・100点満点の画像を生成するのは難しいと思うので、生成した画像を人間がPhotoshop等で微調整するという使用方法が現実的か。

・フリーの画像素材を探すかわりにAIに画像を生成させる、という選択肢が出来た。自分のような絵が下手なプログラマーには嬉しい。

最新記事

- 自社サービス「クイズファミリー」の開発

- ランニングフォームの数値化

- AIに小説を書いてもらう

- AWS Managed Blockchain(AMB)の使用・・・

- APIサービスをどう作るか

- C++による組込みプログラミング

- CUDAでGPUプログラミング

- BERTでチャットボット

- 脆弱性チェックツール

- Flutterでデスクトップアプリ

- MMPoseを使って姿勢推定(骨格検知)

- Laravel Livewire3を使ってみる

- Lineミニアプリ

- RustとPHPのパフォーマンス比較

- ボクシングをモーションキャプチャー

- Virtualbox上のUbuntuにDocker環境を作れ・・・

- AWSでのIPv6対応

- AWSのRDSでブルー/グリーンデプロイ

- 20年ぶりにCOBOL

- フィッシングメールのソースを見る